Il vous arrive parfois de constater une chute de votre trafic organique, et les causes peuvent en être multiples.

De nombreuses études le prouvent : le SEO se positionne aujourd’hui comme l’un des plus puissants leviers webmarketing. Si les bénéfices du référencement naturel sont multiples, force est de constater que certains éléments peuvent venir l’entraver et mettre en échec votre stratégie qui fonctionnait pourtant si bien, du moins sur le papier. Récap’ des 9 raisons principales qui expliquent pourquoi votre stratégie SEO n’aboutit pas aux résultats attendus et pourquoi votre site enregistre une baisse de trafic organique.

Comment diagnostiquer une perte de trafic organique Google ?

Qui dit déploiement d’une stratégie, dit forcément KPIs et outils pour mesurer son efficacité… Mais aussi pour identifier plus facilement les points bloquants et pouvoir intervenir au plus vite pour les corriger. Pour cette raison, nous ne saurons que trop vous conseiller d’utiliser ces deux outils Google in-con-tour-na-bles et de les coupler à d’autres pour avoir une vision 360° de vos performances.

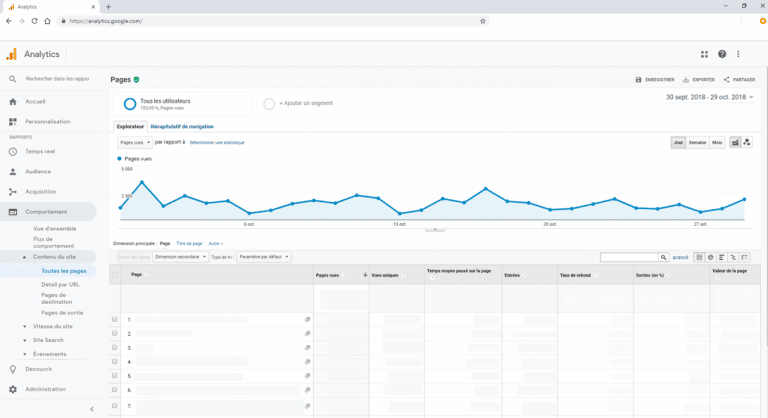

Google Analytics pour une vue d’ensemble de votre trafic et de vos conversions

Votre trafic et vos ventes sont d’excellents indicateurs de la qualité de votre stratégie SEO. L’outil Google Analytics vous permet de mesurer les leads générés par le trafic organique ainsi que le chiffre d’affaires apporté par ces derniers. Identifier les pages qui se positionnent le mieux et drainent le plus de trafic vers votre site vous permet de réorienter votre stratégie marketing en conséquence. L’idéal est de concevoir vos propres tableaux de bord en fonction de vos objectifs et de segmenter votre audience pour distinguer quelles sont les cibles à privilégier pour accroître vos résultats.

Dès le lancement de votre site ou lors de votre refonte, il est donc indispensable d’intégrer immédiatement le code de suivi Analytics pour commencer à collecter des résultats le plus vite possible.

Si vous constatez une baisse significative de trafic, il faut avant tout définir si c’est principalement votre trafic SEO qui est impacté, quelques pages de votre site seulement, ou votre trafic de façon plus générale. Selon les cas, les mesures à prendre ne sont pas les mêmes !

Attention cependant, les données d’Analytics restent globalement moins précises que celles de la Search Console. Les raisons de ces imprécisions sont diverses : erreurs de serveurs, JavaScript non chargé par l’utilisateur… L’idéal est donc de combiner ces deux tools pour une vision globale des performances de votre site.

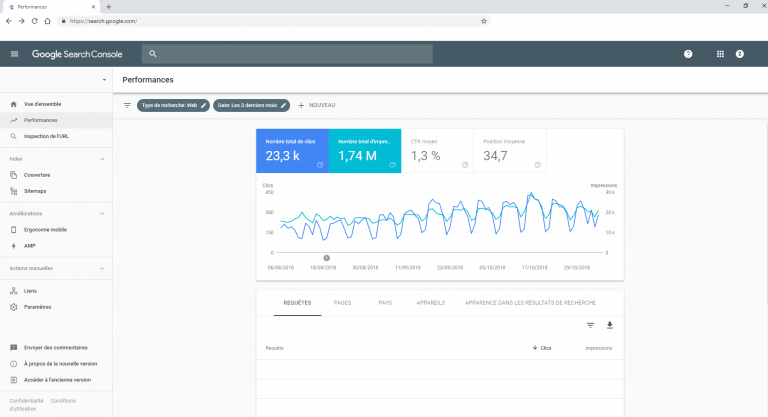

Google Search Console pour surveiller l’évolution de vos KPIs

Indispensable pour n’importe quel référenceur, la Search Console de Google (anciennement Google Webmaster Tools) permet de garder un oeil en permanence sur l’évolution de vos différents KPIs préalablement définis et d’intervenir facilement sur votre site en quelques clics. C’est également le seul outil qui donne le véritable nombre de clics issus du trafic organique.

Vous pouvez savoir précisément :

- les mots-clés sur lesquels votre site se positionne et ceux qui sont les plus générateurs de trafic ;

- le suivi de votre positionnement selon vos mots-clés stratégiques ;

- le CTR (taux de clic) de vos différents liens. Si le pourcentage de clics est faible, cela peut laisser présager qu’une optimisation de vos balises Title et Meta est à réaliser ;

- les différents backlinks qui pointent sur votre site afin d’évaluer la qualité de votre netlinking.

Via cet outil, vous pouvez très rapidement observer si votre site comporte des erreurs sur les fichiers sitemap.xml ou robots.txt, est victime d’un pénalité Google ou encore d’un piratage.

Outils de suivi des positions

Si vous avez l’habitude d’effectuer le suivi quotidien de vos positions, l’avantage est que vous pouvez très rapidement identifier une baisse de trafic et rectifier le tir immédiatement. Pour effectuer cette vérification, nous vous conseillons de répertorier les 20 expressions clés stratégiques les plus génératrices de trafic. Si vous constatez des fluctuations notables deux jours d’affilé, il faut tirer la sonnette d’alarme sans attendre !

Parmi les différents tools à votre disposition, vous pouvez utiliser Ahrefs, SEMrush, Google Search Console ou encore des outils sur mesure développés selon vos besoins, soit par votre expert SEO soit en interne par votre département R&D.

Chez Semji, nous avons conçu notre propre outil qui répertorie tous les indicateurs à surveiller et propose des tableaux de bord qui nous offrent une vision 360° et en temps réel de la situation de nos partenaires.

Demandez une démo pour découvrir les outils de suivi de performance intégrés à la solution Semji.

Chute de trafic SEO : quelles sont les raisons ?

Les algorithmes Google ont été récemment mis à jour

À la vue d’une chute brutale de votre trafic, vous pouvez également suspecter un changement d’algorithme. Généralement, Google communique de façon assez floue les dates des mises à jour de ses algorithmes, et se contente de confirmer l’arrivée d’un nouveau lorsque les premières sanctions significatives affectent des sites. Mais personne ne connaît jamais à l’avance la formule, même si tout le monde connaît les conséquences : gain de positions ou déclassement sur la SERP, voire désindexation… Il arrive aussi qu’un site ne connaisse aucun changement.

Il est évident que votre site ne peut pas évoluer à chaque changement d’algorithme, et la raison est simple : Google procède à des modifications de ses algorithmes plus de 1 500 fois chaque année ! Effectuer rapidement les correctifs nécessaires avant qu’un algorithme ne sévisse n’est pas toujours évident.

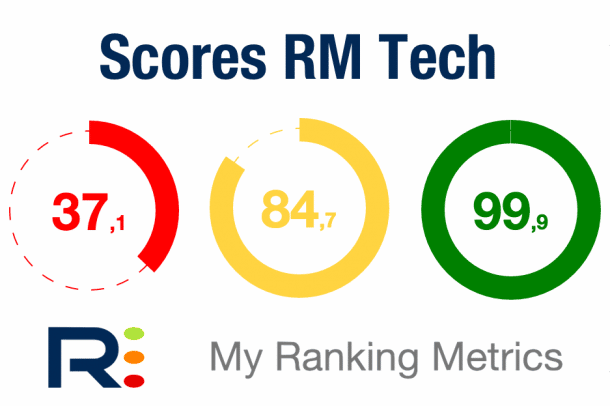

Pour ne plus craindre les changements d’algorithme, le meilleur conseil à appliquer reste de penser et construire L’ENSEMBLE de votre site POUR l’internaute ! Grâce à un audit RM Tech par exemple, vous pouvez vérifier la qualité de votre site et de ses contenus afin d’effectuer les corrections au fur et à mesure.

Votre site n’est pas accessible

Et cela peut concerner un site inaccessible par Google, ou par les utilisateurs. Dans les deux cas, cela est nocif pour votre référencement naturel.

Vous avez prévu de réaliser une maintenance au beau milieu de la nuit en pensant que personne ne visite votre site à ce moment-là ? Vous faites fausse route. Vos visiteurs habituels ne s’y rendent pas, certes. Mais ce n’est pas le cas des Googlebots ! Et s’ils ne peut pas crawler votre site quand ils ont décidé de le faire, ils ne se priveront pas de pénaliser votre site…

Côté utilisateur, un site inaccessible à cause d’une panne de serveur ou d’une erreur de mise à jour est aussi extrêmement négatif. Le type d’erreur affichée lorsque vous essayez de vous rendre sur votre site permet d’identifier de quoi il s’agit : propriété des fichiers et répertoires, erreur de syntaxe du fichier .htaccess, file d’attente du serveur trop encombrée. Dans tous les cas, si le souci vient de votre hébergeur et est récurrent, peut-être qu’il faudrait penser à aller voir ailleurs !

De plus, votre site peut être extrêmement long à charger, si bien que vos visiteurs se découragent et s’en vont aussi vite sur un site concurrent qu’ils pourront consulter. Certaines études révèlent qu’un temps de chargement supérieur à 3 secondes entraîne le départ de la moitié des visiteurs. Les performances du site constituent un critère qui peut jouer en faveur, ou en défaveur, de votre SEO. Be careful !

Votre site rencontre un problème de crawl ou d’indexation

Autre point important à vérifier : est-ce que votre site apparaît bien dans les résultats de recherche ? Si tel n’est pas le cas, penchez-vous sur le paramétrage des fichiers qui permettent le crawl et indiquent aux robots comment procéder, quelles pages et contenus sont à privilégier, ou à ignorer : robots.txt et sitemap.xml. N’oubliez pas de jeter un oeil aux logs serveur qui vous apporteront de précieuses informations !

Concernant le fichier robots.txt : s’il n’est pas renseigné, alors aucun Googlebot ne se rendra sur votre site ! Et votre site ne sera pas crawlé. S’il comporte de mauvaises instructions, vous pouvez clairement vous priver d’un énorme trafic !

Si cette première étape a été correctement réalisée, le souci provient peut-être du fichier sitemap.xml qui comporte des erreurs. Par exemple, il est probable que toutes les URLs de votre site ne soient pas indexées. Pour vous en assurer, il faut comparer le nombre d’URL présentes sur le fichier sitemap.xml, et le nombre d’URL réellement indexées.

Peut-être est-ce uniquement la version site mobile qui est concernée ? Et avec le Mobile First Index, ça peut faire mal… Là encore, la Search Console vous aidera à mettre le doigt sur ces différents points bloquants.

Dans le cas où le crawl est bloqué, l’indexation de vos pages est impossible, et donc vos visiteurs n’ont aucune chance d’accéder à votre site…

Si vous êtes dans le cas d’une refonte SEO, un travail de redirections 301 mal fait peut impacter très négativement votre trafic. D’une part, tous les visiteurs qui cherchent à accéder à votre site par le biais des anciennes URLs n’y parviennent pas et tombent sur une erreur 404. D’autre part, si vous bénéficiez de backlinks et que vous n’avez pas transmis aux sites en question les nouvelles URLs, ou une demande de redirection, alors tout le potentiel trafic en provenance de ces sites est aussi perdu !

Vous avez subi une pénalité Google

Un site victime d’une pénalité Google va forcément connaître une baisse significative de son trafic organique. Deux cas de figure :

- soit le site va perdre des positions sur la SERP, et si ce sont les pages les plus stratégiques qui sont touchées, ça fait très mal.

- soit il n’apparaîtra tout simplement plus sur le moteur de recherche.

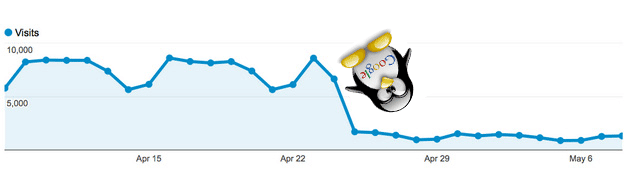

Le plus souvent, les pénalités Google qui touchent un site sont causées par les filtres des algorithmes Panda, Pingouin et Fred. Mais elles peuvent aussi provenir d’une action manuelle, d’un véritable humain !

Si votre site fait l’objet d’une pénalité Panda, c’est que vos contenus sont considérés comme étant de mauvaise qualité (duplicate content, comparateur de prix, fermes à liens).

Si c’est Pingouin qui sévit, alors vous êtes sanctionné à cause d’une sur-optimisation abusive. Elle peut être dûe à des backlinks de mauvaise qualité ou une stratégie d’acquisition de liens qui n’est pas conforme aux guidelines Google (achat, échange, fréquence d’obtention de nouveaux liens suspects…).

Enfin, l’algorithme Fred fait la chasse aux sites qui font un usage abusif des publicités et cherchent en priorité à générer des revenus, au détriment de la qualité des contenus présentés à l’utilisateur. Cela peut se traduire notamment par de nombreux backlinks de faible qualité, trop de spams et d’annonces par rapport aux contenus, des ancres sur-optimisées ou encore un siloing mal défini qui rend la navigation difficile. Un site touché par la pénalité Fred peut voir son trafic chuter de 50%, si c’est votre cas : un sérieux nettoyage s’impose !

Peu importe l’algorithme que vous avez affolé, vous pouvez détecter la nature de la pénalité subie via la Search Console et procéder à la remise à niveau du site. Ensuite, vous pourrez demander un ré-examen afin que votre site soit rétabli dans les meilleurs délais. Dans tous les cas, il est plus que nécessaire d’agir VITE !

Les sites de vos concurrents sont passés devant vous

La bataille est la même pour tous sur Google (et dans la vraie vie aussi d’ailleurs !) : passer devant ses concurrents. Si cet objectif vous anime, dites-vous qu’il en est de même pour vos concurrents !

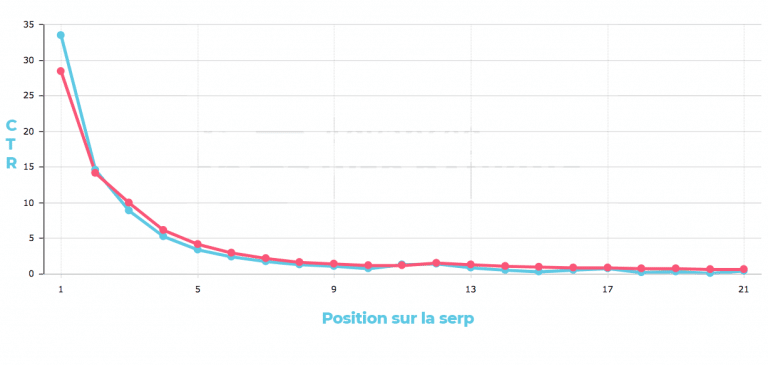

Les sites positionnés dans le TOP 3 sur la SERP grapillent à eux seuls plus de 80% des clics. Dans le cas où votre site soit positionné dans ce TOP, et passe à la 4ème ou 5ème place, il est évident que vous allez perdre une bonne partie du trafic organique habituellement acquis. Pire, si vous atterrissez sur la seconde page, votre visibilité va se retrouver significativement amoindrie !

Vous êtes victime d’un attaque de Negative SEO

Si vous subissez des actions de Negative SEO, c’est que quelqu’un cherche volontairement à vous nuire. Les résultats de telles actions convergent tous vers la même direction : déclassement et désindexation du site. Et à qui pourrait profiter la disparition de votre site ? Ces personnes malintentionnées ne sont autres que vos concurrents. Pourquoi ? Car engager une démarche de Negative SEO à l’encontre d’un site nécessite du temps, de l’énergie, et parfois même de l’argent – mais désamorcer les leaders mérite bien de tels efforts !

La pratique du Negative SEO se résume à utiliser des pratiques relevant du Black Hat SEO. Le but est d’augmenter artificiellement le ranking d’un site en usant et abusant de techniques contraires aux règles imposées par Google… et qui feront l’objet de lourdes sanctions pour le site concerné ! Augmentation brutale de mauvais backlinks, alerte d’une pénalité via la Search Console ou encore chute vertigineuse de votre trafic sont autant de signaux qui doivent vous alerter.

Une attaque de Negative SEO est difficile à prévenir, mais quelques bonnes pratiques vous permettent de la détecter rapidement :

- auditer régulièrement votre site ;

- garder un oeil en permanence sur votre netlinking ;

- vérifier régulièrement le duplicate content qui pourrait être réalisé à partir de votre site.

Suite à des actions de Negative SEO, la réputation que vous avez mis tant de temps à bâtir peut s’écrouler en un rien de temps : une vigilance accrue est de mise !

Votre site a été piraté

À la différence des actions de Negative SEO dont le but est de vous nuire personnellement, le ‘’ hacking SEO ‘’ correspond à un piratage motivé par l’argent et qui a endommagé le score SEO de votre site. Par exemple, un pirate détecte que votre site présente des failles de sécurité et s’en sert pour créer une multitude de pages dans le but de gagner de l’argent via l’affiliation. Il peut par exemple pour diffuser des publicités sur des milliers de pages créées exprès pour l’occasion, sans que vous ne vous en rendiez compte.

Pour éviter de vous retrouver dans cette situation, pensez à faire des mises à jour régulières de votre site, mais aussi des plugins que vous utilisez. Cela vous permettra de patcher rapidement les différentes failles. Si vous utilisez un template préfabriqué via un CMS : vérifiez aussi sa vulnérabilité !

Autant vous dire que tous les sites qui subissent un hack, peu importe sa nature, sont dans le viseur de Google et verront leur score SEO en pâtir sévèrement. Là encore, conserver un haut niveau de vigilance via Analytics, Search Console et les outils de suivi de position. Ils vous permettront de réagir vite, à défaut d’éviter la catastrophe.

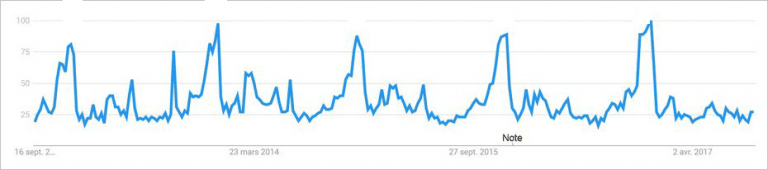

Vos ventes sont saisonnières

Avant de vous affoler car vos visiteurs vous donnent l’impression de déserter votre site, il est important de définir si vos ventes sont saisonnières ou non. Il est évident que le site d’un magasin de location de ski sera bien plus fréquenté durant les vacances d’hiver qu’en plein mois d’août. Pour le site d’un marchand de glaces, ce sera l’inverse. Certains sites événementiels sont aussi fortement sujets à des variations importantes de trafic : pas de panique, c’est tout à fait normal !

Pour réellement savoir si votre site perd anormalement des visiteurs, le mieux est de comparer vos metrics par rapport à la même période l’an passé.

Google Trends peut également vous donner de précieuses informations sur l’évolution du volume de recherche des requêtes. Comme son nom l’indique, cet outil permet d’observer les tendances, et donc de définir si votre situation est en accord avec celles-ci, ou pas !

Comment réagir à la perte de positions sur Google ?

La perte de trafic organique est une situation inconfortable qui peut être subie par n’importe quel site au cours de son existence. Vous n’êtes pas à l’abri ! Si vous y êtes confronté, il est indispensable de savoir quelle attitude adopter pour limiter la casse mais aussi de s’entourer d’experts SEO habitués à gérer ce genre de situation.

Dans un premier temps, l’objectif est d’identifier précisément l’origine de votre chute de trafic : est-elle technique ou malveillante ? Cette donnée est indispensable pour savoir où et comment intervenir. En effectuant quotidiennement un reporting de votre trafic et de votre positionnement, vous réussirez plus facilement à flairer le désastre avant qu’il ne se produise !

La mise en place d’alertes est aussi un excellent moyen de ‘’ prévenir plutôt que guérir ‘’. Grâce à cette méthode, vous pourrez détecter rapidement des actions de Negative SEO par exemple. Tant qu’à faire, surveillez également les dates de mise à jour d’algorithmes : si elles correspondent à celle de la chute de trafic enregistrée, vous savez ce qu’il vous reste à faire…

Dès que vous constatez un changement qui pourrait laisser présager une perte de positions, n’attendez pas pour réagir. Une attitude proactive est le meilleur rempart à une chute de trafic, alors restez sur le qui-vive et soyez prêt à réagir n’importe quand !