On écrit beaucoup de chose et on en lit beaucoup sur la façon dont Google lit / crawle / indexe tous les contenus disponibles sur le web. Qui n’a jamais entendu parler en tant que content manager, rédacteur SEO ou webmarketeur de la fameuse “prime à la fraîcheur” de Google, soit le fait d’apporter régulièrement du contenu nouveau (donc “frais”) à votre site. Mais la production de contenu à tout prix ne doit pas faire oublier qu’un bon contenu est un contenu de qualité, un contenu profond permettant notamment de travailler son maillage interne ! Comment s’en rendre compte ? Nous vous proposons une interview d’Alice Roussel, SEO Operation Manager chez Oncrawl, qui a pu observer sur un site de presse américain que la qualité et la profondeur des contenus impactaient le crawl de Google (et par rebond le positionnement de ces contenus dans la SERP).

Alice Roussel est SEO Operation Manager chez OnCrawl et bénévole (pour le SEO notamment) chez Surfrider, une association engagée dans la protection des océans. Alice a intégré OnCrawl après plusieurs années en agence web.

Pour rappel OnCrawl est un crawler et analyseur de logs SaaS présent principalement en Europe et en Amérique du Nord, primé meilleur outil aux US, EU et Mena en 2019. Oncrawl permet notamment d’accéder à des données de logs de différents secteurs d’activité/ types de site pour comprendre au mieux les schémas de crawl de Google.

Peux-tu nous présenter le client et sa problématique SEO ?

« Il s’agit de l’un de nos utilisateurs Nord-Américain, dans le secteur de la presse économique.

La presse est bien entendu un secteur très concurrentiel, dans lequel évoluent des acteurs historiques mais aussi d’autres plus récents. Le contexte est lui aussi particulier : la presse dans son ensemble a subi de profondes mutations ces dernières années.

Ces différentes évolutions ont eu des impacts sur le volume d’articles publiés par jour, mais également sur la ligne éditoriale : finis les articles longs, les enquêtes et place aux breaking news ! Les effectifs de journalistes, quant à eux, ont eu tendance à diminuer fortement ces dernières années dans la plupart des médias. Moins de rédacteurs, des articles moins longs (ou moins profonds d’un point de vue SEO), et beaucoup plus de brèves… Au final, les différents bouleversements connus par la presse en générale, et par ce journal en particulier ont eu des impacts négatifs sur le référencement naturel de ce journal. »

Qu’avez-vous observé via votre outil de crawl ?

« L’évolution du secteur de la presse, combiné à l’évolution de la SERP de Google, a renforcé le niveau de concurrence sur l’actualité événementielle / breaking news. Ici, l’enjeu de visibilité sur une actualité se joue à la minute près (ex : retranscription d’une keynote, d’une élection politique, etc.). Si Google « crawle » moins bien votre site et surtout moins souvent, les conséquences peuvent être très importantes !

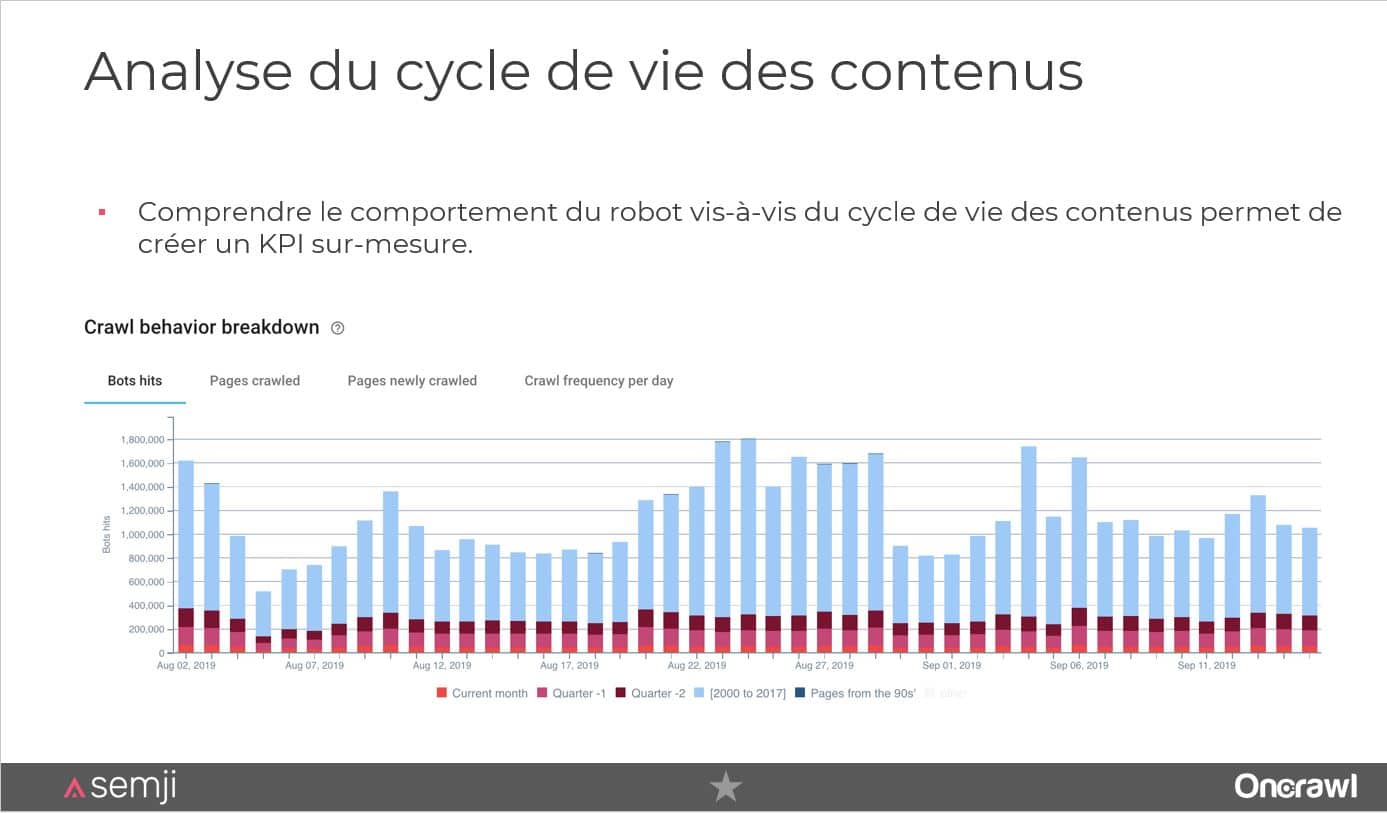

Pour nous, il était intéressant d’avoir une première idée du délai de découverte entre la date et l’heure de publication et le premier crawl de Google mais aussi le délai moyen avant d’obtenir une première visite organique. Pour une analyse granulaire, on a souhaité appliquer notre segmentation historique basée sur la date de publication afin de mieux comprendre le cheminement de Googlebot (ou son schéma de crawl). Pour cela, on a d’abord isolé les anciens articles car ils ne nous intéressaient pas pour les besoins de l’analyse du fait de leur ancienneté et, dans la plupart des cas, de la vétusté de l’information.

Notre segmentation avait un double objectif : illustrer les publications par jour et au mois. »

Comment avez-vous vu qu’un contenu moins qualitatif faisait baisser le passage de Google ?

« Finalement, les premiers résultats que l’on a découvert nous ont conduit à revoir nos velléités d’analyse !

On a remarqué que plus de 80% des « hits » de Google (un hit = une interaction entre Google et le site web) par jour concernaient les anciens articles.

On a rapidement compris pourquoi les articles récents affichaient des différences notables de performances.

De manière générale, les articles de type breaking news fonctionnaient bien en termes de délai de découverte et de ranking là où les articles d’actualité de fond affichaient des performances moindres. La breaking news fonctionne principalement parce qu’elle est un signal fort dans ce secteur d’activité des médias d’actualité mais également parce qu’elle est un signal très important pour l’algorithmie de Google News. Elle est également fortement corrélée à l’autorité du domaine, du fait que l’actualité de type breaking news s’apparente à du remodelage de dépêche Bloomberg, Reuters, etc.

Ce sont donc les articles d’actualité de fond et d’investigation qui ont fini par attirer notre attention et le cœur de notre analyse.

Comme je le disais précédemment, la presse a vécu de nombreux changements ces dernières années. C’est un secteur qui est intimement lié aux évolutions de l’intelligence artificielle (en matière de génération de texte automatique et cela, sans en être la seule raison bien entendu, a conduit à la suppression ou modification de poste de journalistes). Les journalistes d’investigation sont désormais moins nombreux, il y a davantage de pigistes et de rédacteurs par exemple dans les effectifs du journal. Pour le site web dont il est question, leur ligne éditoriale a elle aussi évolué. La baisse des effectifs du journal a conduit à un changement de ligne éditoriale avec moins d’articles d’investigation longs et fouillés, scindés en plusieurs parties. La politique de produire des articles moins denses en termes de volume de mots mais également plus concis en termes de maillage (car moins de parties) a eu un véritable impacte sur la façon dont Google voit, crawle et au final indexe le site !

Dans ce cas précis d’analyse nous avons mis à profit la flexibilité de notre outil pour permettre de visualiser la donnée sous un angle de vue précis dans un premier temps (en l’occurrence la date de publication) et vulgariser la lecture des données de logs pour les rendre plus intelligibles. Il est parfois complexe pour un utilisateur de savoir par où commencer, c’est notre rôle de mettre en lumière les métriques qui nous interpellent. »

Pour aller plus loin sur ce sujet en particulier, nous vous invitions à revoir le webinar donné par Semji et Oncrawl : Créer de nouveaux contenus ou optimiser des contenus existants : quelle stratégie ROIste choisir ? (avec l’intervention de Alice Roussel sur le sujet que nous venons de traiter).

Rappel : Google et les contenus « frais », quelques notions à connaître

Google aime le contenu frais et les publications régulières : c’est l’essence de son fonctionnement (au même titre que l’autorité d’un domaine et le linking). Pendant très longtemps, on a parlé en SEO de « prime à la fraîcheur », un terme qui recouvre en fait plusieurs réalités, dont certaines font maintenant partie d’une sorte de « mythologie du SEO » :

– la prime à la fraîcheur accordée à un site nouvellement mis en ligne : ce serait une sorte de « bonus » accordé par Google pour un site nouvellement mis en ligne pour accorder un peu plus de visibilité alors que vous n’avez pas encore beaucoup de backlinks. Dans sa grande miséricorde, Google aurait placé votre site en bonne position dans les résultats de recherche. Aujourd’hui, cette soit disant prime n’a plus vraiment de sens et ne correspond plus à une réalité observée par la communauté SEO.

– la prime à la fraîcheur pour une page : même principe mais pour une page nouvellement mis en ligne. Un principe qui a pris qui a lui perduré, notamment lorsque Google présente via Matt Cutts (reponsable de Google Webspam jusqu’à l’été 2014) le 8 juin 2010 à la conférence Advanced SMX à Seattle des changements majeurs dans sa façon de crawler les pages sur le web. ces changement porteront le nom de Google Caffeine. L’objectif : rendre la consultation de pages possibles juste quelques secondes après qu’elles aient été trouvées !

Google Caffeine permet d’indexer plus rapidement les nouvelles pages et offre aux internautes la recherche de l’information en temps réel. Dès que Google découvre une nouvelle page, il la décortique et l’indexe immédiatement dans ses bases de données. Elle devient alors accessible aux recherches des internautes. Plus tard le robot va revenir sur la page pour effectuer une analyse plus minutieuse (pour analyser les liens entrants, les liens sortants et autres facteurs de positionnement).

Au moment du lancement de Caffeine, Matt Cutts communiquait sur le fait que ce nouveau fonctionnement de Google permettait d’indexer 50% de résultats plus récents ainsi que de résultats multi-types : réseaux sociaux, images, vidéos etc… Que ceux qui ont eu un blog dans les années 2010 nous jettent la première pierre s’ils n’ont pas fait le test au moment de l’annonce de la sortie de Google Caffeine !

– la production de nouveaux contenus apportés régulièrement à votre site : Google va potentiellement accorder de l’importance à votre site si vous injectez régulièrement du contenu frais ET si vous renouvelez ou mettez à jour fréquemment votre contenu. Pour peu bien entendu que votre site possède de l’autorité et un domaine puissant !

La fréquence de mise à jour est aujourd’hui un critère à prendre en compte tout autant que la fraîcheur. Dans sa quête d’offrir la meilleure réponse possible à un internaute, Google est friand du contenu parfait qui sera le plus tourné vers l’intention utilisateur.

En conclusion Google apprécie le contenu frais, certes, mais également de qualité et qui répond au plus juste aux problèmes et questions des utilisateurs.

Ce principe de « prime à la fraîcheur » a longtemps créé une sorte de dictature de création de contenu, pour le meilleur, mais parfois pour le pire… Comme un potager, le contenu à besoin d’être entretenu et cultivé !

Découvrez comment Semji s’inscrit dans votre stratégie SEO en vous aidant à produire des contenus de qualité qui vous permettent de mieux vous positionner sur la SERP de Google et de répondre aux questions des utilisateurs.

Si vous souhaitez approfondir vos connaissances sur le sujet et évangéliser en interne sur l’importance aujourd’hui de rédiger du contenu SEO qualitatif, à visée ROIste, veuillez remplir ci-dessous notre formulaire pour télécharger notre livre blanc dédié « Comment produire, optimiser, mesurer des contenus GoogleFriendly ?« .